Come molti di voi già sapranno, la registrazione di domini scaduti è diventato, in particolare negli ultimi tre anni, un vero business. Anche in Italia il fenomeno ha preso piede e, fino a poco tempo fa, alle 24.00 il nic veniva intasato di fax di lettere LAR.

Prima di continuare, faccio un breve riepilogo per chi non fosse a conoscenza del fenomeno: a causa di alcune caratteristiche dell’algoritmo di Google, quali:

- la link popularity

- l’importanza data all’età di un sito.

- il pagerank.

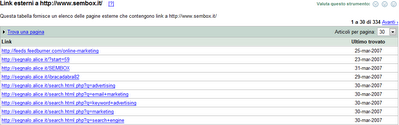

La registrazione di domini scaduti, già presenti nell’indice di Google e, quindi, già linkati da altri siti, era diventata una pratica molto comune per abbreviare i tempi di indicizzazione richiesta dai nuovi siti.

Il fenomeno, in Italia, ha interessato soprattutto aziende che, una volta registrati i siti scaduti, li utilizzavano per la pubblicazione di annunci sponsorizzati, utilizzando principalmente partership con i circuiti di Miva, Yahoo, ecc.

Google in verità aveva già parzialmente risolto il problema, diminuendo di molto il ciclo di vita (circa 30 gg.) di questi siti: un dominio scaduto, una volta “ri-registrato” può essere facilmente individuato grazie ad alcuni fattori: cambio argomenti trattati dal sito, aumento esponenziale delle pagine del sito, ecc.

Il tempo necessario a Google per l’individuazione dei suddetti elementi, rendeva comunque ancora redditizia questa pratica, a chi era riuscito ad automatizza tutte le procedure di registrazione e pubblicazione di nuovi file.

Oggi, per merito (o per colpa del nic) questo fenomeno, almeno per i “.it”, sembra giunto al termine: ho appena scoperto, infatti, che il Registro italiano ha definito nuove linee guida, in particolare ha stabilito che dopo 60 giorni dalla scadenza:”… Il Registro provvede anche a rimuovere le deleghe relative ai nameserver autoritativi per il nome a dominio in oggetto rendendo, di fatto, il nome a dominio non più raggiungibile sulla rete Internet, pur mantenendo però l’assegnazione del nome a dominio stesso al Registrante….“

Semplificando, mentre prima i domini in pending erano comunque raggiungibili dagli utenti e dagli spider dei motori di ricerca (tutti voi vi sarete imbattuti nelle classiche pagine “dominio scaduto” con il logo dell’hosting di turno), ora per 30 giorni i DNS non saranno più risolvibili, ciò renderà irraggiungibili i domini in scadenza.

Questo, presumo, semplificherà di molto l’individuazione dei domini scaduti e quindi la loro esclusione dagli indici dei motori di ricerca, rendendo inutile la registrazione dei domini scaduti.

![]()

![]() ) abbia trovato una risposta significativa su Seotalk, però in compenso avrà scoperto l’estistenaza del SEO

) abbia trovato una risposta significativa su Seotalk, però in compenso avrà scoperto l’estistenaza del SEO ![]()

![]()