Molte sono le fonti che parlano di azioni di Branding sul web e in particolare sui motori di ricerca, ma altrettanti sono i dubbi sull’efficacia di questo tipo di attività tramite i Search Engine.

Per approfondire questa tematica e capire il ruolo dei motori di ricerca in una strategia di branding ci siamo chiesti quali siano i fattori che caratterizzano un’azione di sviluppo del brand on line.

Partendo da una definizione di brand che ci sembra particolarmente esaustiva, possiamo affermare che il Brand si compone di due macro aree:

- La notorietà della marca

- L’immagine della marca

La notorietà della marca comprende tutti quegli elementi legati alla diffusione del brand, che:

- Comunicano al consumatore l’esistenza della marca, promuovendone la conoscenza.

- Facilitano il processo di composizione del paniere di scelte possibili., fornendo un ordine di priorità tra le varie alternative.

- Consentono al consumatore di scegliere un prodotto basandosi su una associazione di familiarità con l’azienda.

L’immagine della marca include tutti quegli elementi che danno vita al rapporto di fiducia tra l’azienda e il consumatore:

- Il consumatore si sente meno esposto a rischi derivanti da un acquisto sbagliato.

- Favorisce una scelta più rapida riducendo i tempi necessari alla valutazione dell’acquisto

A questo punto possiamo trarre delle conclusioni sui fattori sopra elencati che possono trovare applicazione mediante la presenza sui motori di ricerca.

Essendo la notorietà della marca legata sostanzialmente alla presenza, alla possibilità per l’utente di entrare in contatto con un brand e di attribuire un ordine gerarchico alle possibili scelte di acquisto, appare evidente che i motori di ricerca forniscono risposte estremamente idonee ad un’azione di supporto e di brand awareness.

Strategie, invece più incentrate a stabilire un rapporto di fiducia tra il consumatore e l’azienda appaiono più slegate dal concetto di visibilità, e forse meno consone ad essere veicolate tramite i motori di ricerca.

La visibilità della marca, però non sempre favorisce l’auspicata notorietà: apparire in siti di scarsa qualità, di dubbi contenuti e in contesti poco affini all’immagine aziendale può influire negativamente sulla percezione del consumatore.

Il concetto “bene o male basta che se ne parli”, non ci sembra trasferibile nel web, dove invece conviene valutare accuratamente il contesto al quale si vuole agganciare il proprio brand.

Mentre sui motori ricerca, questo è possibile mediante una attenta selezione delle keyword, lo stesso non si può sempre dire dei network di contenuto forniti dagli stessi search engine come canali supplementari di visibilità.

Come è noto a chi mi legge, a volte mi diverto a fare dei paragoni tra la logica umana e il funzionamento degli algoritmi dei motori di ricerca e in particolare di Google.

Alcuni giorni fa mi è stato chiesto di spiegare in modo semplice e senza tecnicismi cos’è la link popularity , come funziona e quali sono i parametri per giudicare un buon link.

Dopo alcuni vani tentativi in cui non riuscivo a far a meno di termini come link in entrata, link in uscita e “autorevolezza” di un sito, sono finalmente riuscito a spiegare, almeno spero, anche ai meno tecnici quali siano le logiche della link popularity senza utilizzare termini tecnici, ma rifacendomi alla vita reale di tutti i giorni.

Immaginate di dover selezionare una persona di alto livello per una importante posizione di lavoro nella vostra azienda, oltre ad affidare le vostre valutazioni al curriculum del candidato, sicuramente cerchereste di raccogliere informazioni e opinioni sulla persona in questione, chiedendo ai vostri colleghi e agli altri specialisti del settore se sono in grado di fornirvi notizie e opinioni sulla persona che state pensando di assumere.

E’ chiaro che maggiori saranno le opinioni positive sul candidato e maggiore sarà la vostra propensione ad assumerlo.

Immaginate se poi un’opinione favorevole vi provenisse da un professionista universalmente riconosciuto, la cosa varrebbe molto di più di 5 consigli provenienti da persone meno valide professionalmente

Ecco spiegati i primi principi che sono alla base di una buona analisi della link popularity:

- Numero di link (opinioni favorevoli)

- Link a Tema (per avere opinioni vi rivolgete agli altri operatori del settore e non a gente estranea al vostro lavoro)

- Autorevolezza del sito linkante

Una volta intrapresa questa strada mi sono accorto che con lo stesso ragionamento è possibile spiegare il concetto di anzianità di un sito web: un curriculum pieno di esperienze professionali positive è senza dubbio più valido di un curriculum, sia pur ben scritto e valido, di un neo laureato.

Ecco qui però entriamo in un penoso problema: la difficoltà per i neo laureati di trovare un lavoro decente!

A quanto sembra questa difficoltà che la società tenta di fronteggiare da anni trova riscontro anche negli algoritmi di Google, infatti ultimamente (almeno questa è la mia opinione) i nuovi siti, se pur molto validi, che riguardano mercati molto competitivi, hanno una grande difficoltà a emergere nelle SERP del noto motore di ricerca a meno che non abbiano una forte raccomandazione(link da siti autorevoli!)

Insomma sembra proprio che Google abbia deciso di proporre a tutti i “neolaureati” una sorta di Stage (periodo definito come sandbox) non retribuito, però è anche vero che alla fine dello stage i candidati validi vengono premiati e assunti a tempo indeterminato, mentre per altri si prefigura il licenziamento, oppure un contratto a progetto davvero poco rassicurante in termini di stabilità

Tag: Link popularity, Sandbox

Oggi, dopo un piacevole scambio di opinioni sulle evoluzioni delle tecniche SEO, ho avuto modo di pensare meglio alla tematica dell’espansione delle query e ai differenti modi in cui questa può essere interpretata.

In particolare il mio interlocutore ha sostenuto che, dopo essersi documentato sulle tecniche di indicizzazione attualmente in uso e sulle possibili future evoluzioni dei motori di ricerca, ha deciso di abbandonare la creazione di pagine fortemente tematizzate su una singola parola chiave, a favore di pagine più ricche di contenuto(generico), che veicolano, quindi, molteplici keyword.

Questa decisione, “naturalmente”, è motivata dalla nuova tendenza dei motori di ricerca, e di Google in particolare, ad “espandere le query”.

Insomma, se ho capito bene la sua opinione, lui sostiene che costruendo una pagina contenente più keyword, come ad es: “prestiti”, “finanziamenti”, “prestiti personali”, ecc, ha più probabilità di posizionarsi per tutti questi termini che non costruendo una pagina per ogni singola parola chiave(quindi con tag title e contenuto incentrato sul singolo argomento specifico).

Certo non posso sostenere che questa opinione sia sbagliata, anche perché se fossi in possesso della verità assoluta su Google mi sarei ritirato a vita privata da molto tempo  , ma personalmente ritengo che “l’espansione della query” non debba influenzare il numero di pagine create, ma il contenuto di ognuna di esse.

, ma personalmente ritengo che “l’espansione della query” non debba influenzare il numero di pagine create, ma il contenuto di ognuna di esse.

Mi spiego meglio: volendo indicizzare un sito per “piccoli prestiti” e per “finanziamenti personali”, io farei 2 pagine con un copy text fortemente incentrato sulla keyword da veicolare.

Certo costruendo la pagina “piccoli-prestiti.html” farei attenzione a riportare con completezza tutti gli argomenti correlati a questa keyword, inserendo il tag title e un titolo alla pagina(in h1) fortemente tematizzato. Costruire una pagina incentrata sia sui finanziamenti personali che sui piccoli prestiti, invece , non mi permetterebbe di poter contestualizzare in modo univoco il contenuto e avrei anche delle difficoltà nel dover costruire il tag title, nel dover definire i titoli interni e gli anchor text con i quali linkare la pagina.

Insomma espansione della query per me significa trattare con completezza ogni singolo argomento(keyword) e non costruire pagine generiche che hanno la pretesa di posizionarsi per tutto.

In fondo anche i target sono diversi, chi cerca piccoli prestiti, o voli Roma, non è interessato ai finanziamenti personali o ai Voli per Napoli  .

.

Non vedo perché la logica utilizzata per costruire le landing pages impiegate nel keyword advertising non possa essere trasportata nel SEO: sono sicuro che fornire una pagina di atterraggio che riporti nel copy text un contenuto fortemente incentrato sulla query effettuata dall’utente possa migliorare di molto le conversioni, rispetto ad una pagina ricca di contenuto, ma disorientante per l’utente, ricordiamoci che i siti hanno l’obiettivo primario di soddisfare le ricerche degli utenti e non le logiche dei motori.

Insomma alla fine il “povero” Googlebot non è altro che un software che deve riuscire a capire il contenuto di una pagina e assegnargli un ranking rispetto ad altri milioni di documenti, quindi se possiamo semplifichiamogli il più possibile la vita

Di ritorno dalle vacanze ho ripreso una delle mia attività preferite: lo spulciamento dei file di log!

Controllando gli accessi degli utenti e degli spider ai siti che seguo, ho notato una caratteristica che sembra accumunare tutti

i domini per i quali ho utilizzato Google Sitemap:una serie di chiamate sequenziali in modalità “head” del caro vecchio Googlebot.

Per i meno tecnici, il metodo HEAD è una variante del metodo GET,

un client che esegue una richiesta di tipo HEAD riceve in output solo le informazioni riguardanti un file (data ultima modifica, ecc), ma non il suo contenuto.

Cercando nel web informazioni in merito, mi sono imbattuto in una discussione sul forum di webmasterworld, dove un utente si è posto la mia stessa domanda: perchè Googlebot effettua questa tipologia di chiamata?

Tra i pareri, più o meno contrastanti, emersi nella discussione, l’opinione più diffusa sembra essere che Googlebot potrebbe utilizzare il metodo head per controllare la

data di aggiornamento dei file, risparmiando un bel po’ di banda e di risorse:

“Probably checking for last modified or if the file exists without downloading it.”

La risposta sembrerebbe logica, quello che non mi spiego è, se proprio l’intento è quello di risparmiare banda, perchè le chiamate in modalità head si ripetono a distanza di pochi secondi, richiedendo sempre lo stesso file?:

66.249.72.65 – - [05/Sep/2006:09:50:01 +0200] “HEAD / HTTP/1.1″ 200 0 “-” “Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)”

66.249.72.65 – - [05/Sep/2006:09:50:11 +0200] “HEAD / HTTP/1.1″ 200 0 “-” “Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)”

66.249.72.65 – - [05/Sep/2006:09:50:20 +0200] “HEAD / HTTP/1.1″ 200 0 “-” “Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)”

66.249.72.65 – - [05/Sep/2006:09:50:23 +0200] “HEAD / HTTP/1.1″ 200 0 “-” “Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)”

66.249.72.65 – - [05/Sep/2006:09:50:29 +0200] “HEAD / HTTP/1.1″ 200 0 “-” “Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)”

66.249.72.65 – - [05/Sep/2006:09:50:35 +0200] “HEAD / HTTP/1.1″ 200 0 “-” “Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)”

Continuerò ad indagare, nel frattempo se avete opinioni in merito sono ben accette!

Lo sanno tutti ma in pochi lo dicono: il settore nel quale si sono sviluppate per primo delle tecniche volte a migliorare l’indicizzazione e il posizionamento di un sito è stato il mercato del porno.

In particolar modo in Italia dal 1999 al 2003 abbiamo assistito ad un autentico far west dei dialer.

Molti sono state le società che si sono arricchite a suon di 2€ di connessione al minuto, e come spesso succede, anche in questo settore la maggior parte delle visite generate dai siti, proveniva dai motori di ricerca.

Certo le tecniche di posizionamento utilizzate in questo settore non erano tra le più evolute: largo utilizzo di keyword stuffing, altissima keyword density e un bel po’ di testo nascosto, ma la cosa deve aver funzionato bene, a giudicare dal volume di soldi che ruotavano intorno a queste società.

Dopo la stangata del 2003, questo settore nel web ha fatto registrare un vistoso calo di affari, ma è tutt’altro che morto.

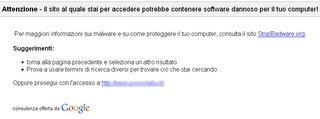

Il colpo di grazia potrebbe, però, arrivare dallo stesso Google, che a quanto sembra ha aggiunto un nuovo filtro, almeno io non lo conoscevo, che si frappone tra il click sulla pagina del motore di ricerca e il sito finale:

Sul forum di html sembra essersi già sviluppata una discussione sull’argomento.

Eccomi di ritorno dalle vacanze e già alle prese con la vita reale

Prima di iniziare a parlare di Google e compagni, però, devo assolutamente fare gli auguri a Simone per il suo nuovo progetto, che a quanto sembra oltre all’interesse per il SEO, condivide con me anche un’altra passione!

Dopo alcuni disguidi con la mia assicurazione auto (più che altro con il mio assicuratore) , ho deciso di confrontare i preventivi e le offerte delle altre società di assicurazione.

Sarò malato, ma dopo quattro agenzie dove mi sono sentito ripetere le stesse cose, ho capito che Google ha copiato di sana pianta il suo algoritmo dal mondo delle assicurazioni auto!

Leggendo le possibilità che mi sono state paventate dalle varie agenzie potrete rendervene conto anche voi:

- Se nel mio nucleo familiare ho una persona che usufruisce della prima classe, come parente posso partire dalla nona e non dalla 14 classe, come la norma vorrebbe. (Trustrank)

- I nuovi assicurati pagano di più, poi man mano che passano gli anni, senza avere sinistri, si sale di categoria. (Una specie di Sandbox e anzianità del dominio)

- Se l’assicurazione accerta che un assicurato ha fatto una falsa segnalazione di sinistro, oppure ha ingigantito il danno alla vettura, quest’ultimo viene automaticamente declassato in 15 classe, oppure non gli viene più rinnovata l’assicurazione (Penalizzazione e BAN)

- Se più parenti, appartenenti allo stesso nucleo familiare, si servono nella stessa casa di assicurazione, si possono avere ulteriori vantaggi (una sorta di Link Popularity)

- Se con un’auto si sono avuti più sinistri, cambiando automobile, lo stesso proprietario può usufruire di alcuni vantaggi e riaprire un nuovo contratto assicurativo, anche con la stessa società (insomma bannato un dominio il proprietario può sempre registrarne altri

)

)

Dopo aver colto queste similitudini, mi sono messo alla ricerca di un modo per ottenere più vantaggi e tariffe più convenienti per la mia assicurazione, si sa mai che funzioni anche con Google

Anche il nostro settore ha quest’anno il tormentone estivo: tutti ormai, nei forum italiani e non, parlano dell’arrivo del nuovo spider di Google dedicato a stabilire la qualità delle landing pages utilizzate dagli inserzionisti adwords.

Questo nuovo valore qualitativo, se ho capito bene, sarà utilizzato per stabilire il livello di bid minimo di un investitore in base alla qualità della landing page utilizzata.

Quando ho appreso la notizia ho cercato di individuare quali caratteristiche potrebbero essere analizzate dal nuovo spider per stabilire la qualità di una landing page, visto che per sua natura questa pagina non deve contenere molte informazioni(in modo da non distogliere l’utente dall’azione che vogliono fargli compiere), deve essere graficamente accattivante e deve veicolare in modo forte una call to action.

Ieri sera parlando con Marco Fontebasso, che saluto, mi ha suggerito un nuovo modo di vedere la cosa: ho sempre creduto che Google avesse implementato analytics per registrare i dati di conversione degli investitori adwords (unico dato che attualmente non ha), però non avevo mai pensato che questi dati potrebbero anche essere usati per individuare le principali caratteristiche delle landing che hanno convertito di più, in modo da estrapolare delle regole generali che potrebbero essere alla base del nuovo algoritmo.

Penso proprio che mi toccherà fare lo stesso lavoro, analizzando le caratteristiche comuni che esistono tra le landing pages delle nostre campagne che hanno convertito di più.

Anche se le conversioni, mi suggerisce Paola, possono dipendere anche da un sacco di altri fattori come la coerenza tra la creatività e la landing pages, il brand del cliente, la convenienza del servizio offerto ecc.

Questa mattina, analizzando i dati di conversione di alcune campagne di keywords advertising, Paola mi ha fatto notare una cosa molto strana: al contrario del circuito di Google, su Yahoo Search Marketing, le keywords generiche(assicurazioni, finanza, ecc) registrano un livello di conversione molto elevato.

In un primo momento ho cercato di spiegarmi il fenomeno prendendo in considerazione le diverse caratteristiche dei target ai quali le due piattaforme si rivolgono, ma la spiegazione non mi sembrava essere molto convincente.

Successivamente analizzando i risultati di adwords per query specifiche (es: assicurazioni motociclo 50cc, assicurazione casa, ecc.) ho potuto constatare, all’interno del circuito di Google, la presenza di molti siti riportanti i risultati di Yahoo Search Marketing (i cosiddetti arbitrage ).

Più nel dettaglio ricercando su google “assicurazione casa”, e cliccando su uno degli arbitrage presenti nei risultati adwords un utente atterra su una landing page riportante i risultati di Overture per “assicurazione” e non per la reale ricerca effettuata dall’utente.

In questo caso alla piattaforma di Yahoo Search Marketing è stata lanciata una query diversa da quella originale(“assicurazione” vs “assicurazione casa”) generando così la perdita dell’informazione riguardante la ricerca iniziale.

Una eventuale conversione, dall’ex circuito di Overture, verrà assegnata pertanto come correlata al termine generico, mentre l’utente aveva in principio digitato una query specifica.

Se questo discorso fosse plausibile, e il traffico generato dagli arbitrage fosse in grado di influenzare significativamente i dati della piattaforma di advertising, si potrebbero trarre due conclusioni principali:

- i dati di conversione forniti da Yahoo search marketing sono parzialmente falsati

- su questo circuito è molto più importante investire sulle keywords generali e non sulle parole specifiche e magari adottare delle creatività “neutre” associabili anche a ricerche più dettagliate.

Gestire una campagna di search advertising con obiettivi di vendita e ROI è indubbiamente un’operazione complessa che richiede un’attenta selezione ed analisi delle parole chiave utilizzate: si parte con un set di parole chiave ampio per poi operare degli aggiustamenti e concentrarsi sulle parole che hanno generato maggiori conversioni.

Questa logica schiacciante deve però tener conto del processo d’acquisto degli utenti, che nelle fasi iniziali della ricerca, utilizzano parole chiave generiche come “voli” “compagnie aeree online” o “assicurazioni online” per poi definire le proprie ricerche con keywords sempre più specifiche come “voli a cuba” o “assicurazioni auto Direct Line”.

Il successo di una campagna sui motori di ricerca è legato alla capacità di essere presenti durante tutte le fasi del processo d’acquisto, trovando un equilibrio tra parole generiche, tipicamente più costose e keywords più specifiche, che costano meno, generano conversioni più elevate ma rischiano di limitare il potenziale di vendita di quei prodotti e servizi che richiedono un processo di acquisto più articolato.

Ad esempio nel settore travel, utilizzando strumenti di tracciamento che monitorano le conversioni legate alle parole chiave impiegate per la prima ricerca, si registra, durante il periodo estivo, un maggior numero di conversioni generate da parole generiche come “volo” o “viaggio low cost”. Questa tendenza si spiega considerando che l’acquisto della vacanza estiva presuppone un processo d’acquisto generalmente più lungo ed articolato rispetto all’acquisto di un utente che prenota un volo per lavoro, probabilmente con maggior frequenza durante l’anno e sa esattamente di cosa ha bisogno.

Se poi pensate che, secondo una ricerca effettuata in occasione del Search Engine Strategies di New York sono necessarie mediamente 65 ricerche prima di effettuare un acquisto online e che il 75% delle keywords utilizzate dagli utenti sono di carattere generico, è evidente che i termini generalisti sono assolutamente rilevanti in una campagna di successo.

Per concludere vorrei quindi fare un paio di considerazioni sugli strumenti di bid management e di day parting che operano in una logica di ottimizzazione, dando visibilità alle parole che convertono di più e nelle ore più redditizie, riducendo la presenza di parole apparentemente meno performanti: questi strumenti sono chiaramente utili purchè non si sottovalutino il potenziale di conversione e i tempi di latenza nel processo di acquisto degli utenti. Idealmente si dovrebbe effettuare un’analisi di medio-lungo periodo delle campagne e tenere in considerazione la stagionalità del business: a questo punto si possono settare delle regole che consentono massima visibilità alle parole più performanti, mantenendo comunque la presenza delle keywords utilizzate da utenti meno avvezzi al mezzo e con un processo d’acquisto più lento.